小優智能科技有限公司成立于2015年底,是一家專注于高精度3D機器視覺模組研發、生產及銷售的高科技企業。

公司自主研發的3D機器視覺模組采用激光/DLP白光編碼光柵結構光+雙工業相機方案,還原物體三維信息,廣泛應用于消費電子領域、工業領域和安防領域,具有精度高、速度快、成本低的優勢。

近年來,三維數據測量技術的發展和相關坐標測量設備的逐漸普及,使得三維數據的獲取越來越便捷。三維數據測量技術作為三維重建技術中的重要組成部分,目前常見的三維數據測量方式分為接觸式和非接觸式兩大類[1-4]。

接觸式方法是利用某些儀器通過實際接觸直接測量場景的三維數據,典型代表是三坐標測量機(簡稱CMM),在工業測量領域中用來測量某些小體積重要零部件[5]。在生產制造過程中,用三坐標測量機對機械配件和模具進行測量和獲得尺寸數據是最有效的方法之一,因為它可以代替多種表面測量工具及昂貴的組合量規,并把復雜的測量任務所需時間從小時減到分鐘,這是其它儀器而達不到的效果。接觸式方法所得數據精度較高,受環境因素影響小,但成本高昂,只適用于表面標準幾何尺寸較多的物體,在待測物體曲面比較復雜、物體表面柔軟易變形和物體表面幾何尺寸較少等場合的應用受到一定限制。更重要的是,使用接觸式測量法獲得物體的大量三維點云數據非常困難。

非接觸式方法與接觸式方法不同,非接觸式方法是在測量時不接觸被測量的物體,與其保持一定距離,通過光、聲音、磁場等媒介來獲取目標數據[6]。該方法對目標物體和測量環境要求低,雖然測量精度比接觸式測量法低,但隨著科學技術的發展,非接觸方法的測量精度有了較大的提高。在目前的三維重建領域中,非接觸式測量法相比接觸式測量方法應用領域更加廣泛。

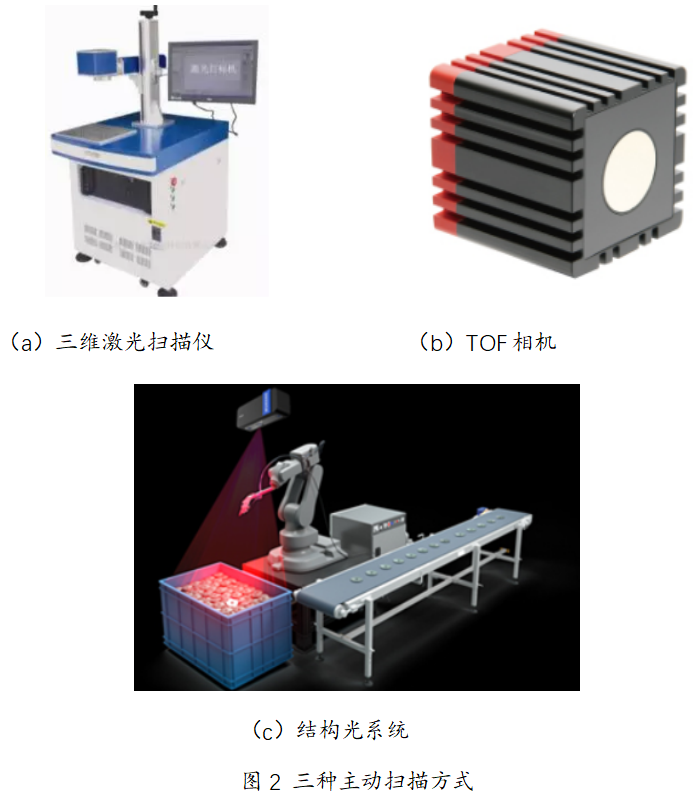

非接觸式根據掃描方式不同又分為主動掃描和被動掃描,如圖2所示,主動掃描常見有三維激光掃描技術[7]、TOF(Time-of-Flight)相機[8]、結構光系統[9]等。

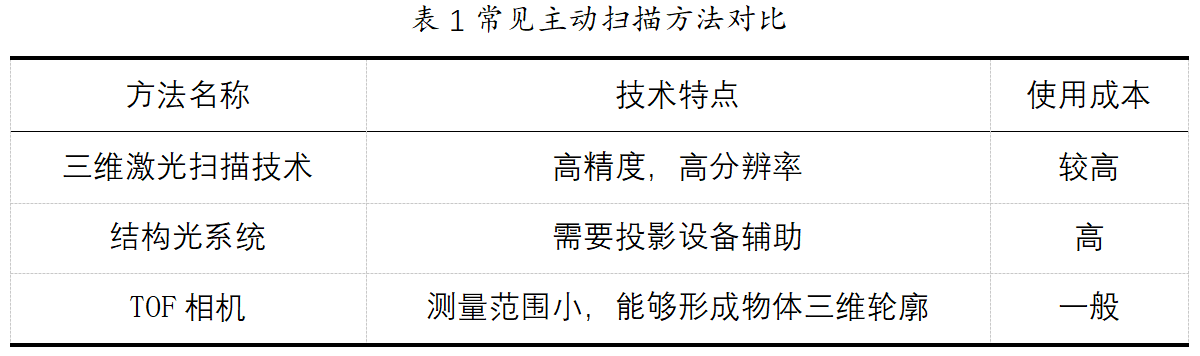

三維激光掃描技術又被稱為實景復制技術,對待測物體或場景發出激光點或線性激光束,通過光電元件接收待測物反射的光線,計時器測定激光束從發射到接收的時間,以此計算出待測物體到設備之間的距離。這種方法在于可得到較準確的深度信息,并且可記錄大量的、密集的點的坐標,缺點是價格高昂以及數據信息量大。Omari等人[10]提出了將三維激光掃描技術應用于建筑項目中進度報告的生成,在不同時間通過三維激光掃描儀掃描建筑工地生成數據,然后將其用于估計兩次連續掃描的時間間隔之內執行的工作量,以此提高從建筑工地收集數據的速度和準確性。Ghahremani等人[11]提出了一種借助手持式三維激光掃描儀獲取點云來保證高頻機械沖擊處理質量的方法,該方法對五個焊接式樣進行了不同程度的沖擊處理然后使用手持式三維激光掃描儀掃描焊口的點云數據,通過測量點云幾何參數確定不同的沖擊處理。

TOF相機利用經過調制的近紅外光探測目標物,傳感器計算光線往返所需時間換算出物體與設備之間的距離而獲取深度信息,結合傳統的相機拍攝,就能將物體的三維輪廓以不同的顏色代表不同的距離表示出來。這種方法可以快速簡便得到深度數據,不需多余的輔助掃描設備,缺點是價格相比普通相機仍然偏高,測量結果受被測物性質影響,系統誤差及隨機誤差對結果影響明顯。Heide等人[12]將場景重建公式變為場景的瞬態響應上的線性逆問題,從二階漫反射中恢復了視線之外的物體,利用TOF相機獲取場景信息,從而有效地重建了大型房間場景。Koutsoudis等人[13]利用TOF相機對希臘克桑西地區的奧斯曼帝國紀念碑進行三維重建,通過對紀念碑完整三維模型的數字分析,質疑了運動結構-密集多視圖3D重建(簡稱SFM-DMVR)方法的適用性。

結構光是一組由投影儀和攝像頭組成的系統結構,用投影儀投射特定的光信息到物體表面后及背景后,由攝像頭采集。根據物體造成的光信號的變化來計算物體的位置和深度等信息,進而復原整個三維空間[14]。結構光系統的優點在于獲取圖像數據的質量較好,但需要多個攝像頭進行協調配合工作,且受光照條件影響較大,對系統要求較高。Deetjen等人[ 15]提出了一種新的針對相機-投影儀這類結構光系統的自動校對方法,該方法通過自動圖像處理和捆綁調整參數優化實現校準,可以應用在質量控制,自主系統,工程測量和運動捕捉等領域。Heist等人[16]提出了一種“5D傳感器”,該傳感器通過結構光快速準確的測量表面形狀和光譜特性,該傳感器提供了出色的空間和光譜分辨率,出色的深度精度和高幀頻,可以應用在醫學成像,精密農業或光學分揀等領域。表1對常見掃描方法做出了對比。

Reference:

[1] 王亞琪. 基于Kinect的軸類零件三維重建關鍵技術研究[D].青島理工大學, 2015.

[2] Otto K N. Product design: techniques in reverse engineering and new product development[M]. 清華大學出版社有限公司, 2003.

[3] 王亞琪, 陳成軍, 李希彬. 基于Kinect的軸類零件三維重建研究[J]. 計算技術與自動化, 2015(4): 126-131.

[4] 徐超, 李喬. 基于計算機視覺的三維重建技術綜述[J]. 數字技術與應用, 2017, 28(1): 54-56.

[5] 韋羽棉. 基于Kinect深度圖像的三維重建研究[D]. 重慶大學, 2014.

[6] Hinton G E, Osindero S, Teh Y W. A fast learning algorithm for deep belief nets[J]. Neural computation, 2006, 18(7): 1527-1554.

[7] Michalos G, Karagiannis P, Makris S, et al. Augmented reality (AR) applications for supporting human-robot interactive cooperation[J]. Procedia CIRP, 2016, 41: 370-375.

[8] Chen P, Peng Z, Li D, et al. An improved augmented reality system based on and AR[J]. Journal of Visual Communication and Image Representation, 2015, 37:63-69.

[9] Henderson S, Feiner S. Exploring the benefits of augmented reality documentation for maintenance and repair[J]. IEEE Transactions on Visualization and Computer Graphics, 2011, 17(10): 1355-1368.

[10] El-Omari S, Moselhi O. Integrating 3D laser scanning and photogrammetry for progress measurement of construction work[J]. Automation in Construction, 2008, 18(1): 1-9.

[11] Ghahremani K, Safa M, Yeung J, et al. Quality assurance for high-frequency mechanical impact (HFMI) treatment of welds using handheld 3D laser scanning technology[J]. Welding in the World, 2015, 59(3): 391-400.

[12] Heide F, Xiao L, Heidrich W, et al. Diffuse mirrors: 3D reconstruction from diffuse indirect illumination using inexpensive Time-of-Flight sensors[C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2014: 3222-3229.

[13] Koutsoudis A, Vidmar B, Ioannakis G, et al. Multi-image 3D reconstruction data evaluation[J]. Journal of Cultural Heritage, 2014, 15(1):73-79.

[14] Morgan W D, Lester H M. Stereo realist manual[M]. 1954.

[15] Deetjen M E, Lentink D. Automated calibration of multi-camera-projector structured light systems for volumetric high-speed 3D surface reconstructions[J]. Optics express, 2018, 26(25): 33278-33304.

[16] Heist S, Zhang C, Reichwald K, et al. 5D hyperspectral imaging: fast and accurate measurement of surface shape and spectral characteristics using structured light[J]. Optics express, 2018, 26(18): 23366-23379.