小優智能科技有限公司成立于2015年底,是一家專注于高精度3D機器視覺模組研發、生產及銷售的高科技企業。

公司自主研發的3D機器視覺模組采用激光/DLP白光編碼光柵結構光+雙工業相機方案,還原物體三維信息,廣泛應用于消費電子領域、工業領域和安防領域,具有精度高、速度快、成本低的優勢。

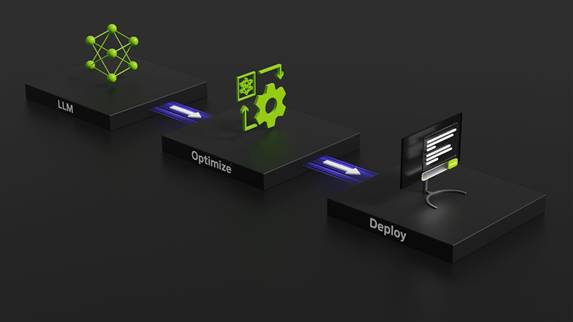

淺談TensorRT加速原理

英偉達TensorRT是一種專門為深度學習推理優化的庫,它充分利用GPU的并行計算能力,加速神經網絡模型的推斷過程。基于 NVIDIA TensorRT 的應用程序在推理過程中的執行速度比純 CPU 平臺快達 36 倍,能夠優化在所有主要框架上訓練的神經網絡模型,以高精度校準較低精度,并部署到超大規模數據中心、嵌入式平臺或汽車產品平臺。在時下流行的LLM大模型推理加速中,NVIDIA TensorRT-LLM開源庫更是大放異彩。TensorRT-LLM 加速了用于生成 AI的最新大型語言模型,性能提高了 8 倍,TCO 降低了 5.3 倍,能耗降低了近 6 倍。目前TenorRT框架已經成為在英偉達GPU上部署深度學習模型的不二之選。下面我們將從幾個主要方面淺談TensorRT框架推理加速的原理。

注:圖片來自英偉達TensorRT SDK官網 https://developer.nvidia.com/tensorrt

一、精度校準:

1. FP16量化:

FP16(半精度浮點數)是指使用16位二進制表示浮點數,相較于傳統的32位浮點數,占用更少的存儲空間,并能夠在GPU上進行更高效的運算。TensorRT支持將模型的權重和激活函數的精度從FP32減少到FP16,從而減小了內存占用和計算復雜度。FP16量化在深度學習推理中通常能夠保持良好的模型準確性,特別是對于計算資源有限的嵌入式設備或移動平臺而言。

2. INT8量化:

INT8(8位整數)量化更進一步地減小了模型的存儲需求和計算開銷。在INT8量化中,模型參數和激活值都被量化為8位整數,從而顯著減小了內存占用和運算開銷。為了將浮點數量化為整數,通常需要通過離散化的方法,例如乘以一個縮放因子并進行四舍五入。雖然INT8量化引入了量化誤差,但在許多實際應用中,可以通過合適的校準和訓練來保持模型的高精度。

3. TensorRT支持的精度校準方法:

TensorRT提供了幾種方法來進行精度校準,以滿足不同的應用需求:

1)統一精度校準(Unified Precision Calibration): TensorRT使用統一的方法將FP32模型量化到FP16或INT8,適用于大多數深度學習模型。

2)自定義精度校準(Custom Calibration): 允許用戶自定義量化過程,以便更好地適應特定模型結構和需求。

3)在線精度校準(Online Calibration): 允許在模型推斷過程中進行在線校準,動態適應模型的輸入數據分布。

這些方法使得開發者能夠根據應用場景的不同選擇合適的精度校準策略,權衡模型精度和推理性能。

通過使用TensorRT的精度校準功能,開發者可以靈活地選擇適合其應用場景的量化方法,在提高推理速度的同時,最大限度地保持模型的準確性。這對于在嵌入式系統、移動設備等資源有限的環境中進行深度學習推理非常重要。

二、層融合:

層融合是通過將多個網絡層組合成一個更大的層,以減小計算負擔,提高推理性能的技術。層融合在TensorRT中通過一系列優化技術和規則實現,下面詳細描述一下TensorRT中的層融合過程:

層融合的具體過程:

規則定義: TensorRT使用一系列規則來確定哪些層可以被融合以及如何融合。這些規則考慮了網絡的拓撲結構和支持的操作。例如,卷積層和激活函數(如ReLU)常常可以被融合在一起,以減少內存訪問和計算負擔。

融合操作的選擇: 一旦確定了可以融合的層,TensorRT會選擇合適的操作將它們融合在一起。例如,對于卷積層和激活函數的融合,可以將它們組合成一個新的操作,稱為卷積-激活(Convolution-ReLU)操作。這樣做的好處是避免了在兩個層之間傳遞數據的需要,減少了內存開銷。

融合參數的調整: 在層融合的過程中,TensorRT可能會調整融合操作的參數,以保持模型的準確性。例如,它可能會調整激活函數的閾值,以適應新的融合操作。

重復應用規則: 層融合是一個迭代的過程,TensorRT會多次應用規則,嘗試找到最優的融合策略。這樣可以確保在最大程度上減小計算負擔的同時,保持模型的準確性。

三、多流執行:

英偉達TensorRT具備用于并行處理多個輸入流的可擴展設計的能力,這種能力使得在實際應用中能夠高效地處理多個輸入數據流,適用于實時、多通道、或者批處理的場景。以下是TensorRT在多輸入流處理方面的詳細描述:

多輸入流處理的可擴展設計:

多流插槽(Multistream Slots): TensorRT引入了多流插槽的概念,允許在單個TensorRT引擎中并行處理多個輸入流。每個流插槽都關聯著一個輸入流,使得多個輸入數據流能夠獨立地傳遞到TensorRT引擎中。

圖優化的并行處理: TensorRT對圖進行優化時,會考慮多個輸入流的并行性。這包括層融合、算法選擇等優化步驟,確保每個輸入流都能夠充分利用GPU的并行計算能力。

動態擴展性: TensorRT的設計考慮到了動態擴展性,允許在運行時動態添加或刪除流插槽。這使得在應對不同數量輸入流的情況下能夠靈活地調整系統設計,適應實時場景或批處理需求。

Batch大小和流的關聯: TensorRT支持在圖的優化和推理過程中將Batch大小與流插槽關聯起來。這樣,不同輸入流的Batch大小可以是獨立的,滿足實際應用中不同流的數據分布。

GPU資源管理: TensorRT在處理多個輸入流時,能夠有效管理GPU資源。通過合理地分配GPU資源,TensorRT可以使不同輸入流的推理過程相互獨立,充分利用GPU的計算能力。

四、內核自動調整:

英偉達TensorRT可以基于目標 GPU 平臺選擇最佳數據層和算法,具體實現方法如下:

硬件特性識別: TensorRT能夠識別目標GPU平臺的硬件特性,包括CUDA架構、CUDA核心數量、存儲器帶寬等。這使得TensorRT能夠充分利用目標硬件的并行計算能力,選擇適合該硬件的算法和數據層。

算法選擇: TensorRT通過優化和選擇適當的算法,以最大限度地發揮目標GPU的性能。這包括選擇高效的卷積實現、優化的矩陣運算等。TensorRT根據目標GPU的架構和性能特點,選擇在該硬件上執行最佳的深度學習算法。

數據層選擇: 不同的GPU架構對于數據的訪問模式有不同的要求,包括存儲器帶寬、緩存大小等。TensorRT可以根據目標GPU的特性選擇最佳的數據層,以優化內存訪問模式,提高數據的加載和傳遞效率。

精確的性能模型: TensorRT利用對GPU硬件的深入了解,建立了精確的性能模型。這使得在模型推理前,TensorRT能夠預測不同部分的計算時間,并基于這些預測進行一系列的優化,包括層融合、精度校準等,以提高整體推理性能。

通過這些能力,TensorRT能夠實現對目標GPU平臺的智能適配,充分發揮硬件的性能潛力,提供高效的深度學習推理。這對于在不同硬件環境中部署深度學習模型,實現最佳性能至關重要。

五、動態張量顯存:

動態張量內存技術通常指的是在運行時動態分配和管理張量(Tensor)內存的能力。這種技術對于處理變長序列、動態形狀(Dynamic Shapes)或者在推理過程中動態修改模型結構的情況非常有用。

動態分配和釋放內存: TensorRT可能具有在運行時根據實際需要動態分配和釋放張量內存的能力。這對于不同批次大小或輸入形狀的情況非常有用。

支持變長序列: 對于處理變長序列的任務,例如自然語言處理中的自然語言理解(NLU),動態張量內存技術可以使得模型能夠適應不同長度的輸入序列。

TensorRT運行時引擎: TensorRT的運行時引擎包括一些智能的內存管理機制,以便更靈活地處理動態張量。這可能涉及到內存池管理、動態內存分配算法等。

注:圖片來自英偉達TensorRT官網介紹https://developer.nvidia.cn/tensorrt

總體而言,TensorRT的加速原理是通過一系列優化技術和并行計算來最大程度地提高深度學習推理的速度。這些技術包括精度校準、層融合、多流執行、內核自動調整及動態張量顯存。通過使用TensorRT,開發者可以在保持模型準確性的同時,顯著提高推理性能,從而更好地滿足實時和高效的深度學習應用需求。

如有侵權,聯系刪除。